Introduction

Indexer des milliers, voire des millions de pages web, représente un défi majeur pour les propriétaires de sites volumineux ou dynamiques. Entre les limites d’exploration de Googlebot, la nécessité de gérer une arborescence complexe et l’obtention de liens entrants suffisants pour gagner en autorité, il peut sembler fastidieux d’amener les moteurs de recherche à explorer et à indexer tout ce contenu. Dans cet article, nous allons découvrir pourquoi l’indexation à grande échelle est cruciale, quelles sont les méthodes préconisées pour l’accélérer et comment optimiser au mieux son SEO on-page pour soutenir cet objectif. Nous verrons également comment d’autres propriétaires de sites, confrontés à la même problématique, ont mis en place différentes stratégies, parfois ingénieuses, pour encourager Googlebot à parcourir leurs pages plus rapidement et efficacement.

Pourquoi indexer des milliers de pages est crucial

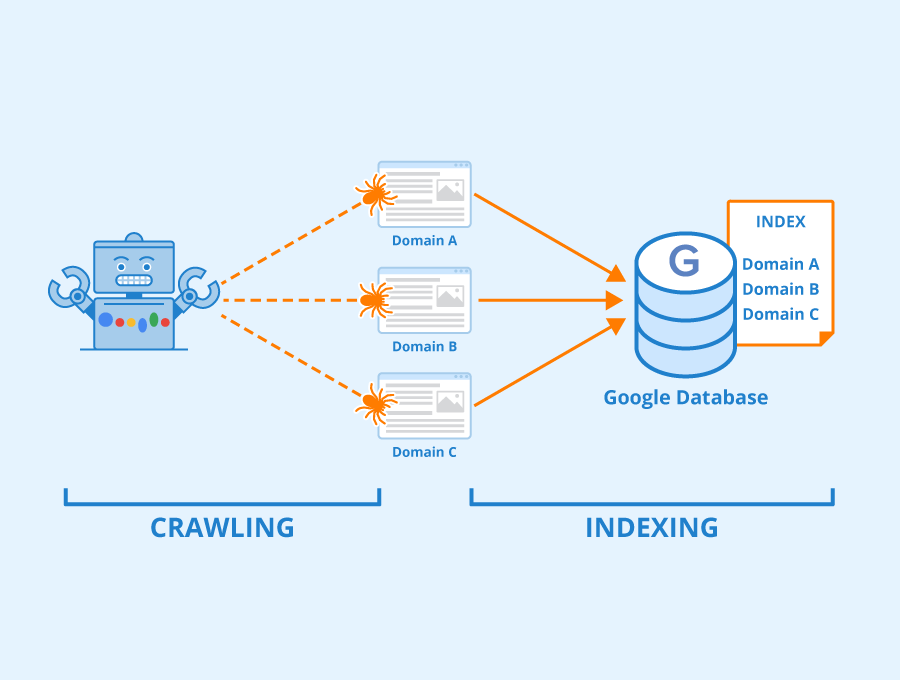

Lorsqu’un site internet regroupe plusieurs centaines de milliers, voire des millions de pages, il est essentiel de rendre ce contenu accessible et visible pour les internautes. Google (et les autres moteurs de recherche) ne peuvent pas tout parcourir en un claquement de doigts, surtout si le site est récent ou peu reconnu. Une indexation limitée se traduit par un manque de trafic organique, donc un manque d’opportunités commerciales ou de lectorat, malgré la richesse potentielle des données.

Par ailleurs, la surcharge d’erreurs techniques, la profondeur excessive de l’arborescence ou le manque de liens externes peuvent freiner considérablement le processus d’indexation. Les entreprises, les services publics ou même les start-ups qui souhaitent proposer un volume très élevé de pages se retrouvent donc face à un véritable enjeu : comment faire en sorte que Googlebot (ou Bingbot) découvre, parcoure et indexe effectivement chaque ressource ? Le problème se pose particulièrement pour des sites d’annuaires, d’open data ou d’archives historiques.

Favoriser une structure claire et performante

Améliorer l’architecture

Une arborescence logique et hiérarchisée est l’un des premiers leviers. Si les pages importantes sont enfouies sous cinq niveaux de clics, Googlebot risque de les ignorer ou de prendre énormément de temps à les atteindre. Au contraire, un maillage interne bien pensé, où chaque section est accessible via des liens cohérents, permet de présenter clairement la structure au robot d’exploration. Il s’agit de relier les pages entre elles pour éviter des “îlots” isolés ou un trop grand nombre d’URL en profondeur.

Pour y parvenir, les professionnels du SEO conseillent généralement de ne pas dépasser trois ou quatre clics pour accéder à n’importe quelle page. Les “index” ou les “catégories” doivent jouer un rôle de passerelle vers des sous-sections, qui elles-mêmes renvoient à des listings plus détaillés. Ainsi, Googlebot progresse sans heurt et découvre graduellement l’ensemble des contenus.

Gérer les liens internes et les liens aléatoires

Plusieurs experts suggèrent aussi d’intégrer des blocs de liens aléatoires ou contextuels. Par exemple, un sidebar affichant dynamiquement des liens vers des pages moins mises en avant, afin d’inciter Googlebot à effectuer des allers-retours et à découvrir l’ensemble du site. Cela peut s’implémenter sous forme de “articles similaires”, “pages connexes” ou “random picks”, en veillant à respecter un certain équilibre pour ne pas noyer l’utilisateur sous trop de liens.

En parallèle, il convient de supprimer ou de corriger les liens brisés (erreurs 404) pour éviter que Googlebot ne perde du temps dans des impasses. Les outils tels que Screaming Frog sont très pratiques pour détecter ces anomalies et mettre en place des redirections 301 si nécessaire.

Optimiser la popularité et la performance pour encourager l’exploration

Obtenir des liens entrants

Même si la structure interne est primordiale, le rythme de crawl dépend également de l’autorité perçue du domaine. Plus un site est reconnu, plus Googlebot a tendance à y revenir fréquemment pour découvrir les nouveautés. C’est pourquoi renforcer la popularité via des liens externes qualitatifs est un axe fort pour un site ambitionnant d’indexer un grand volume de pages.

Il s’agit d’obtenir, au fil du temps, des backlinks émanant de sites fiables et thématiquement proches. Plusieurs personnes soulignent que le fait de construire 5 à 10 bons liens par jour, ou de développer des partenariats avec des acteurs de son secteur, finit par accélérer le rythme d’exploration. Les robots comprennent que ce site, régulièrement cité, doit être crawlé plus fréquemment pour ne pas manquer de nouveaux contenus.

Stabiliser la vitesse et la propreté du code

L’autre facteur décisif réside dans la vitesse de chargement et la propreté technique. Un site lent ou renvoyant des erreurs 500 aura tendance à voir son crawl réduit, car Googlebot ne souhaite pas gaspiller de ressources sur un site peu performant. Au contraire, un site offrant des temps de réponse bas, sans duplicate content exagéré, et sans URL paramétriques confuses, recevra un meilleur crédit du robot.

La mise en cache, l’optimisation des images, la compression GZIP, ou encore l’hébergement sur un serveur robuste figurent parmi les leviers recommandés. En outre, certaines entreprises mettent en place un “crawl loop” ponctuel en affichant massivement des liens internes : un tel pic d’exploration doit être anticipé, car si le serveur ne suit pas, cela peut se retourner contre l’initiative.

Stratégies d’indexation à grande échelle

Utiliser les sitemaps, sans crainte

Beaucoup craignent de soumettre un volumineux sitemap sur un domaine récent, de peur d’éveiller la suspicion de Google. Cependant, la plupart des avis convergent : si le site propose un contenu unique et de qualité, il n’y a pas de raison de s’en priver. Un sitemap scindé en plusieurs sections thématiques peut guider Googlebot et éviter qu’il ne “s’égare” ou doive deviner la hiérarchie.

Dans Google Search Console, il est possible d’ajuster le taux de crawl. Sur un site tout neuf, laisser le moteur décider est souvent préférable. Mais au fur et à mesure que la notoriété grandit, le propriétaire peut opter pour un crawl plus agressif, si le serveur le permet. Les chiffres varient, mais on voit des exemples de sites passant de 500 pages indexées par jour à plusieurs milliers ou dizaines de milliers, dès lors que le PageRank (ou l’autorité) augmente et que l’architecture est optimale.

Développer un “API mindset”

Pour certains sites possédant des millions de pages, offrir une API publique ou des widgets de partage peut multiplier les liens entrants profonds. Plus il y a de gens qui relaient, utilisent et référencent une ressource interne précise, plus Google va la juger “importante” et la crawler régulièrement. C’est l’une des stratégies abordées par des experts : pousser d’autres sites à pointer vers des segments spécifiques du contenu.

Cela implique de développer une couche d’interaction : blog, forum, zone communautaire, ou toute fonctionnalité incitant les utilisateurs à partager le lien d’une page donnée. Si le site offre un service ou des données très recherchées (ex. annuaires, dossiers, open data), l’effet viral peut être conséquent, améliorant l’indexation à long terme.

Études de cas

Cas d’un site de 8 millions de pages

Dans un forum, un propriétaire mentionnait avoir commencé avec 8 millions de pages, avec un robot Google se limitant à 500 pages explorées par jour. D’après les retours, deux axes ont fait la différence : obtenir quelques partenariats majeurs (un gros site de la même thématique pointant vers les rubriques-clés) et optimiser la navigation interne en créant plusieurs niveaux d’index. En l’espace de six mois, la cadence de crawl a grimpé, permettant d’indexer plusieurs centaines de milliers de pages.

Cas d’un e-commerce avec 500 000 références

Un e-commerce proposant plus de 500 000 références produits était confronté à un faible taux d’indexation et un crawl rate de l’ordre de quelques centaines de pages par jour. Après avoir effectué un audit technique pour supprimer les URL obsolètes, configurer correctement le sitemap (en le fragmentant par catégories), et solliciter des partenariats d’influenceurs en ciblant les catégories stratégiques, l’enseigne a vu les pages crawlées passer à 3 000 – 5 000 par jour en quelques mois. Les ventes issues du SEO ont nettement augmenté, prouvant la corrélation entre une indexation profonde et la performance commerciale.

Points clés et mise en pratique

Indexation massive ne rime pas automatiquement avec spam : de nombreuses structures possèdent réellement des millions de pages utiles, qu’il s’agisse de bases de données, d’archives ou d’informations de niche. Pour s’assurer que Googlebot parcourt et indexe cette masse, plusieurs facteurs sont à combiner : une architecture limpide, des liens internes appropriés, un volume d’erreurs minime et un nombre suffisant de backlinks externes pour renforcer la notoriété du site. Lorsque ces ingrédients sont réunis, la cadence de crawl peut grimper considérablement, transformant ce qui aurait pris des décennies en quelques mois seulement.

Check-list finale :

- Organiser le site : créer des sections et des index logiques, limiter la profondeur de navigation.

- Assurer la performance technique : vitesse de chargement, correction des erreurs 404/500, absence de duplicate content.

- Soumettre un sitemap : scinder éventuellement en plusieurs parties si le site est très vaste.

- Renforcer les liens entrants : partenariats, relais sur d’autres sites, API ou widgets incitant au partage.

- Examiner régulièrement Google Search Console : surveiller les problèmes d’indexation, ajuster le crawl si nécessaire.

- Maintenir une stratégie de contenus : publier régulièrement des pages de qualité pour prouver que le site est actif et légitime.

- Favoriser le partage communautaire : forum, blog, badges d’utilisateur, microformats, tout ce qui peut pousser à des backlinks externes.

Résumé en quelques lignes :

– Pour indexer des milliers ou des millions de pages, il faut d’abord soigner la structure et la performance.

– Les liens entrants et la notoriété augmentent la fréquence de crawl.

– Sitemaps, random links, mises à jour régulières et partenariats sont des méthodes efficaces pour encourager l’exploration à grande échelle.